DeepSeek-V3, ultragrote open-source AI, presteert bij de lancering beter dan Llama en Qwen

Sluit u aan bij onze dagelijkse en wekelijkse nieuwsbrieven voor de laatste updates en exclusieve inhoud over toonaangevende AI-dekking. Meer informatie

De Chinese AI-startup DeepSeek, bekend om het uitdagen van toonaangevende AI-leveranciers met zijn innovatieve open-sourcetechnologieën, heeft vandaag een nieuw ultragroot model uitgebracht: DeepSeek-V3.

Verkrijgbaar per Knuffelend gezicht Volgens de licentieovereenkomst van het bedrijf wordt het nieuwe model geleverd met 671B-parameters, maar gebruikt het een mix van experts-architectuur om alleen geselecteerde parameters te activeren, om bepaalde taken nauwkeurig en efficiënt uit te voeren. Volgens door DeepSeek gedeelde benchmarks staat het aanbod nu al bovenaan de hitlijsten, presteert het beter dan toonaangevende open-sourcemodellen, waaronder Meta’s Llama 3.1-405B, en komt het nauw overeen met de prestaties van gesloten modellen van Anthropic en OpenAI.

De release markeert een nieuwe belangrijke ontwikkeling die de kloof tussen gesloten en open-source AI dichtt. Uiteindelijk ontstond DeepSeek, dat begon als een uitloper van het Chinese kwantitatieve hedgefonds Kapitaalbeheer voor hoogvliegershoopt dat deze ontwikkelingen de weg zullen vrijmaken voor kunstmatige algemene intelligentie (AGI), waarbij modellen het vermogen zullen hebben om elke intellectuele taak die een mens kan, te begrijpen of te leren.

Wat brengt DeepSeek-V3 met zich mee?

Net als zijn voorganger DeepSeek-V2 maakt het nieuwe ultragrote model gebruik van dezelfde basisarchitectuur waar het om draait latente aandacht met meerdere hoofden (MLA) En DeepSeekMoE. Deze aanpak zorgt ervoor dat er efficiënte training en gevolgtrekking wordt gehandhaafd – waarbij gespecialiseerde en gedeelde ‘experts’ (individuele, kleinere neurale netwerken binnen het grotere model) voor elk token 37 miljard parameters van de 671 miljard activeren.

Hoewel de basisarchitectuur robuuste prestaties voor DeepSeek-V3 garandeert, heeft het bedrijf ook twee innovaties geïntroduceerd om de lat nog verder te verleggen.

De eerste is een aanvullende, verliesvrije strategie voor taakverdeling. Hiermee wordt de belasting van experts dynamisch bewaakt en aangepast om ze op een evenwichtige manier te gebruiken zonder de algehele modelprestaties in gevaar te brengen. De tweede is multi-token voorspelling (MTP), waarmee het model meerdere toekomstige tokens tegelijkertijd kan voorspellen. Deze innovatie verbetert niet alleen de trainingsefficiëntie, maar zorgt er ook voor dat het model drie keer sneller presteert en 60 tokens per seconde genereert.

“Tijdens de pre-training hebben we DeepSeek-V3 getraind op 14,8T hoogwaardige en diverse tokens… Vervolgens hebben we een uitbreiding van de contextlengte in twee fasen uitgevoerd voor DeepSeek-V3”, schreef het bedrijf in een technisch papier detaillering van het nieuwe model. “In de eerste fase wordt de maximale contextlengte uitgebreid tot 32K, en in de tweede fase wordt deze verder uitgebreid tot 128K. Hierna hebben we post-training uitgevoerd, waaronder Supervised Fine-Tuning (SFT) en Reinforcement Learning (RL) op het basismodel van DeepSeek-V3, om het af te stemmen op menselijke voorkeuren en het potentieel ervan verder te ontsluiten. Tijdens de post-trainingsfase distilleren we het redeneervermogen uit de DeepSeekR1-modellenreeks, en bewaren we ondertussen zorgvuldig de balans tussen modelnauwkeurigheid en generatieduur.”

Tijdens de trainingsfase heeft DeepSeek met name gebruik gemaakt van meerdere hardware- en algoritmische optimalisaties, waaronder het FP8-framework voor gemengde precisietraining en het DualPipe-algoritme voor parallellisme van pijpleidingen, om de kosten van het proces te verlagen.

Over het geheel genomen beweert het de volledige training van DeepSeek-V3 te hebben voltooid in ongeveer 2788K H800 GPU-uren, of ongeveer $5,57 miljoen, uitgaande van een huurprijs van $2 per GPU-uur. Dit is veel lager dan de honderden miljoenen dollars die gewoonlijk worden uitgegeven aan het vooraf trainen van grote taalmodellen.

Llama-3.1 is bijvoorbeeld naar schatting getraind met een investering van meer dan $500 miljoen.

Het sterkste open-sourcemodel dat momenteel beschikbaar is

Ondanks de economische training is DeepSeek-V3 het sterkste open-sourcemodel op de markt gebleken.

Het bedrijf voerde meerdere benchmarks uit om de prestaties van de AI te vergelijken en merkte op dat deze overtuigend beter presteert dan toonaangevende open modellen, waaronder Llama-3.1-405B en Qwen 2.5-72B. Het presteert zelfs beter dan closed-source GPT-4o op de meeste benchmarks, behalve de op het Engels gerichte SimpleQA en FRAMES – waar het OpenAI-model voorop liep met scores van respectievelijk 38,2 en 80,5 (vs. 24,9 en 73,3).

Opvallend is dat de prestaties van DeepSeek-V3 vooral opvielen in de Chinese en op wiskunde gerichte benchmarks, en beter scoorden dan alle tegenhangers. In de Math-500-test scoorde het 90,2, waarbij Qwen’s score van 80 de op één na beste was.

Het enige model dat DeepSeek-V3 kon uitdagen was Claude 3.5 Sonnet van Anthropic, die beter presteerde met hogere scores in MMLU-Pro, IF-Eval, GPQA-Diamond, SWE Verified en Aider-Edit.

Het werk laat zien dat open-source closed-source-modellen nadert en vrijwel gelijkwaardige prestaties belooft voor verschillende taken. De ontwikkeling van dergelijke systemen is buitengewoon goed voor de industrie, omdat het mogelijk de kans elimineert dat één grote AI-speler het spel regeert. Het geeft bedrijven ook meerdere opties om uit te kiezen en mee te werken terwijl ze hun stapels orkestreren.

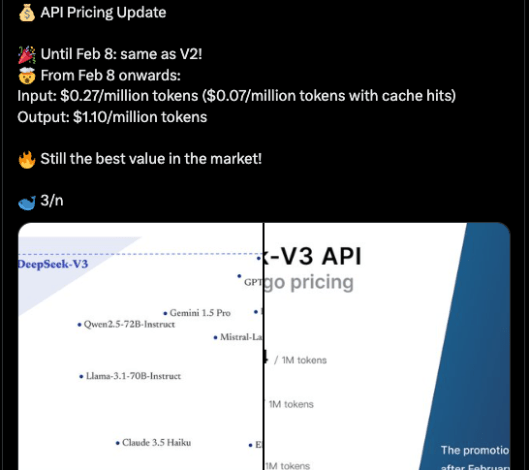

Momenteel is de code voor DeepSeek-V3 beschikbaar via GitHub onder een MIT-licentie, terwijl het model wordt geleverd onder de modellicentie van het bedrijf. Bedrijven kunnen het nieuwe model ook testen via DeepSeek-chateen ChatGPT-achtig platform, en toegang tot de API voor commercieel gebruik. DeepSeek levert de API op de dezelfde prijs als DeepSeek-V2 tot 8 februari. Daarna zal het $0,27/miljoen inputtokens ($0,07/miljoen tokens met cachehits) en $1,10/miljoen outputtokens in rekening brengen.

Source link