Deelt uw iPhone standaard foto’s met Apple?

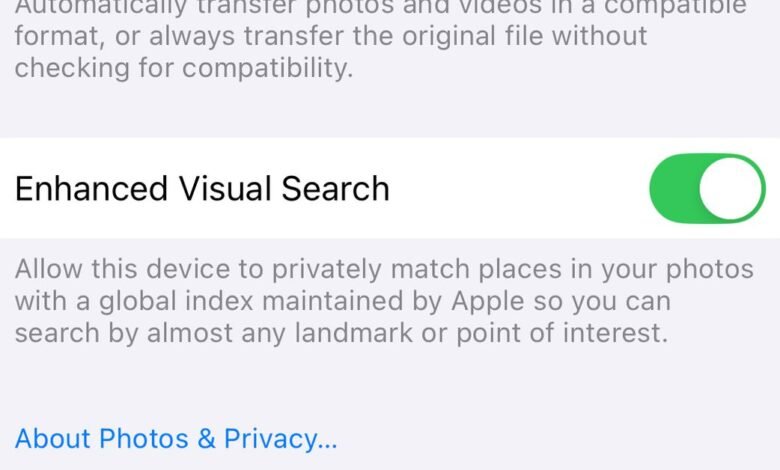

En ja hoor, toen ik vanochtend mijn iPhone 15 Pro controleerde, stond de schakelaar aan. Je kunt het zelf vinden door naar Instellingen > Foto’s te gaan (of Systeeminstellingen > Foto’s op een Mac). Met Verbeterd Visueel Zoeken kunt u oriëntatiepunten opzoeken waarvan u foto’s hebt gemaakt, of naar die afbeeldingen zoeken met behulp van de namen van die oriëntatiepunten.

Om te zien wat dit mogelijk maakt in de Foto’s-app, veegt u omhoog over een foto die u van een gebouw hebt gemaakt en selecteert u ‘Oriëntatiepunt opzoeken’. Er verschijnt een kaart die het gebouw idealiter identificeert. Hier zijn een paar voorbeelden van mijn telefoon:

Op het eerste gezicht is het een handige uitbreiding van de Visual Look Up-functie van Photos die Apple in iOS 15 introduceerde, waarmee je planten kunt identificeren of bijvoorbeeld kunt ontdekken wat die planten zijn. symbolen op een waslabel betekenen. Maar Visual Look Up heeft geen speciale toestemming nodig om gegevens met Apple te delen, en dit is wel het geval.

In een beschrijving onder de schakelaar staat dat je Apple toestemming geeft om “plaatsen in je foto’s privé te matchen met een globale index die door Apple wordt bijgehouden.” Wat betreft hoe, er zijn details in een Onderzoeksblog over machine learning van Apple over Enhanced Visual Search waarnaar Johnson linkt:

Het proces begint met een ML-model op het apparaat dat een bepaalde foto analyseert om te bepalen of er een ‘region of interest’ (ROI) is die een oriëntatiepunt kan bevatten. Als het model een ROI in het “landmark”-domein detecteert, wordt voor dat gebied van de afbeelding een vectorinbedding berekend.

Volgens de blog wordt die vectorinbedding vervolgens gecodeerd en naar Apple gestuurd om te vergelijken met zijn database. Het bedrijf biedt een zeer technische uitleg van vectorinbedding in een onderzoekspaperMaar IBM heeft het eenvoudiger gezegdwaarin wordt geschreven dat inbedding “een datapunt, zoals een woord, zin of afbeelding, transformeert in een N-dimensionale reeks getallen die de kenmerken van dat datapunt vertegenwoordigen.”

Net als Johnson begrijp ik de onderzoeksblogs van Apple niet volledig en Apple reageerde niet onmiddellijk op ons verzoek om commentaar over de zorgen van Johnson. Het lijkt erop dat het bedrijf zich tot het uiterste heeft ingespannen om de gegevens privé te houden, deels door beeldgegevens te condenseren in een formaat dat leesbaar is voor een ML-model.

Toch lijkt het een betere optie geweest om de opt-in-schakelaar te gebruiken, zoals die voor het delen van analysegegevens of opnames of Siri-interacties, in plaats van iets dat gebruikers moeten ontdekken.