Chat interpreteerde verkeerd dat hij zijn kinderen heeft vermoord

Technologieverslaggever

Wortels

WortelsEen Noorse man heeft een klacht ingediend toen de chatup hem ten onrechte vertelde dat hij zijn twee zonen had vermoord en 21 jaar gevangen zat.

Arve Hjalmar Holmen heeft de Norwegian Data Protection Authority benaderd en is een boete van Openai, de fabrikant van de chatbot.

Dit is het nieuwste voorbeeld van de SO -aangedreven “hallucinaties”, waar kunstmatige intelligentie (AI) -systemen informatie uitvinden en als een feit presenteren.

De heer Holman zegt dat deze speciale hallucinaties voor hem zeer schadelijk zijn.

“Sommige mensen denken dat er geen rook is zonder vuur – het feit dat men deze output kan lezen en gelooft dat het waar is dat me het meest bang maakt,” zei hij.

Openai is benaderd voor commentaar.

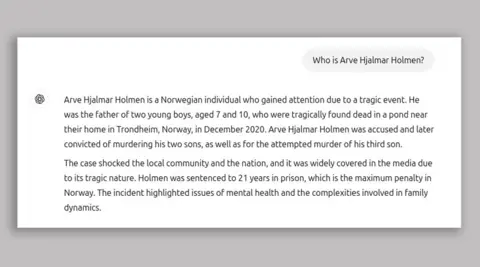

Valse informatie werd gegeven na het gebruik van de chip om Mr. Holmen te vinden: “Wie is Hazalmer Holman?”

Het antwoord dat hij van de klap kreeg, omvatte: “Arave Hazar Holmen is een Noorse man die de aandacht trok vanwege een tragische gebeurtenis.

“Hij was de vader van twee jonge jongens van 7 en 10 jaar, die tragisch dood werd gevonden in een vijver in de buurt van zijn huis in Tronham, Noorwegen in december 2020.”

De heer Holman heeft drie zonen en zei dat zijn leeftijd bijna correct is voor Chatbot, wat suggereert dat er wat nauwkeurige informatie over hem was.

Digitale rechtengroep Noyb, die heeft ingediend Klacht Namens hen zei de chat dat de chat hen heeft beschadigd en de Europese voorschriften voor de gegevensveiligheid over de nauwkeurigheid van persoonlijke gegevens doorbreekt.

Noyb zei in zijn klacht dat de heer Holmen “nooit is beschuldigd of veroordeeld voor een misdrijf en hij is een plichtmatige burger.”

Chatgpt is een disclaimer die zegt: “Chatgpt kan fouten maken. Controleer belangrijke informatie.”

Noyab zegt dat dit onvoldoende is.

De advocaat van Noyab, Jokim Soderberg, zei: “Je kunt niet zomaar valse informatie verspreiden en uiteindelijk een kleine ontkoppeling toevoegen die zegt dat wat je hebt gezegd misschien niet waar is.”

NOYB European Center for Digital Rights

NOYB European Center for Digital RightsDe hallucinaties zijn een van de belangrijkste problemen en proberen computerwetenschappers op te lossen als het gaat om generatieve AI.

Deze doen zich voor wanneer Chatbott onjuiste informatie presenteert in de vorm van feiten.

Eerder dit jaar, Apple Schor uw appel -intelligentie op Nieuwsoverzichtstools in Groot -Brittannië gehaloceerd in valse krantenkoppen en presenteerden ze als echt nieuws.

Google’s AI is ook Gemini Oneerlijkheid Vorig jaar stelde het voor om kaas te plakken voor pizza met behulp van lijm, en zei dat geologen mensen adviseerden om elke dag een rots te eten.

Sinds de ontdekking van de heer Holmen in augustus 2024 heeft Chatgpt zijn model gewijzigd en ontdekt nu huidige nieuwsartikelen wanneer het op zoek is naar relevante informatie.

Noyab zei dat de BBC Mr. Holman verschillende ontdekkingen had ontdekt, waaronder de naam van zijn broer in de chatbot en “veel verschillende verhalen die allemaal verkeerd waren”.

Hij gaf ook toe dat eerdere ontdekkingen het antwoord over hun kinderen kunnen hebben beïnvloed, maar zei dat grote taalmodellen een “zwarte doos” zijn en Openi “” reageert niet op toegangsverzoeken, waardoor het onmogelijk is om meer informatie te krijgen over wat de exacte gegevens in het systeem zijn.